Tylko ci, którzy mają jasną strategię, wychodzą z rozgrywki jako zwycięzcy. W erze sztucznej inteligencji kluczowymi zawodnikami dla firmy są dane i infrastruktura. Konferencja HPE Innovation Day 2025 odbywała się na stadionie warszawskiej Legii w konwencji sportowej.

Kompletny ekosystem

– AI Factories to ostatnio bardzo gorący temat – wprowadziła do dyskusji Magdalena Kasiewicz, hybrid cloud sales lead w firmie HPE Polska. – Zastanówmy się więc, czym one są.

– Nazwa jest trochę myląca – wyjaśniła Pamela Krzypkowska, dyrektorka Departamentu Badań i Innowacji w Ministerstwie Cyfryzacji. – Ludzie spoza branży mają wrażenie, że coś się w nich produkuje. Pytają: „Co się w nich dzieje? Jakie produkty z nich wychodzą?”. Z drugiej strony jest to nazwa o tyle wartościowa, że pokazuje namacalność sztucznej inteligencji, czego, jak mi się wydaje, w dyskursie publicznym czasem brakuje. Czym w takim razie jest AI Factory? To infrastruktura obliczeniowa umożliwiająca budowanie zaawansowanych systemów sztucznej inteligencji dla konkretnych potrzeb. Na przykład gdy chcemy wytrenować model językowy PLLuM czy Bielik albo stworzyć zaawansowany system do przewidywania pogody, wówczas AI Factory może pomóc nie tylko nam, ale także naukowcom, przedsiębiorcom i administracji publicznej, żeby te modele językowe tworzyć i dostarczać na rynek.

– AI Factory to znacznie więcej niż sprzęt – stwierdził Robert Pękal, pełnomocnik dyrektora ds. Poznańskiego Centrum Superkomputerowo-Sieciowego. – To kompletny ekosystem, na który składają się warstwy technologii: sprzęt, oprogramowanie, aplikacje i platformy. Jednak jego absolutnym fundamentem, decydującym o sukcesie, są ludzkie kompetencje. To właśnie połączenie zaawansowanych narzędzi z wiedzą ekspertów pozwala budować przewagę konkurencyjną i wdrażać rzeczywiste rozwiązania. Dlatego AI Factory należy rozumieć jako zintegrowaną całość, w której technologia jest multiplikatorem ludzkich kompetencji w procesie tworzenia innowacyjnych produktów.

Suwerenność cyfrowa

Warto także pamiętać o suwerenności cyfrowej. Ostatnio to bardzo gorący temat. Co jest zatem dziś kluczowym elementem suwerenności, zwłaszcza w erze sztucznej inteligencji, która – jak się często podkreśla – jest już wszechobecna w tej chwili?

– Bez wątpienia suwerenność cyfrowa jest bardzo ważna – podkreśliła Pamela Krzypkowska. – Polecam wszystkim raport inicjatywy Eurostack, który analizuje cały łańcuch dostarczania cyfrowych rozwiązań powiązanych z kompetencjami. Co z niego wynika, szczególnie dla Europy i naszego kraju? Co w Europie mamy naszego? Odpowiedź jest pozornie prosta. Zawsze mówimy, że mamy w Polsce świetnych programistów. Moim zdaniem, AI Factories to kluczowy element suwerenności, ponieważ to my nimi zarządzamy w całości: decydujemy, co się w nich dzieje i powstaje. Dzięki temu możemy budować suwerenność cyfrową na wyższych poziomach, software’owym oraz kompetencyjnym. Jest to niesłychanie ważne. Dlaczego informatycy wyjeżdżają z Polski? Chcą pracować z najlepszymi naukowcami i tworzyć superprojekty. A teraz my im to umożliwiamy. Budujemy ekosystem, zapewniając pełną suwerenność, jeżeli chodzi o dostęp do danych i modeli sztucznej inteligencji.

– Tak, to prawda – dodał Robert Pękal. – Kwestia ta dotyczy nie tylko samych modeli, lecz również fizycznej lokalizacji danych. Aby zapewnić im prawdziwą suwerenność, musimy je przechowywać w Polsce. Chcę przy tym jasno podkreślić: nie mam nic przeciwko usługom hiperskalerów i chmurze publicznej jako takiej. Jednak strategiczne kategorie danych, dotyczące bezpieczeństwa państwa i polskich obywateli, bezwzględnie powinny być przechowywane i przetwarzane w krajowej infrastrukturze.

– Nie zgadzam się, że AI Factories nic nie produkują – zaoponował Andrzej Jankowski, artificial intelligence sales engineer EMEA Territory w firmie Intel. – Dyskutujemy o generatywnej sztucznej inteligencji. Ona w jakimś stopniu właśnie generuje tokeny, czyli kolejne słowa lub obrazy. I druga sprawa: to dzisiaj truizm, ale dane są absolutną podstawą wszystkich procesów. I naturalnie nie chcielibyśmy przekazywać naszych danych gdziekolwiek na zewnątrz, gdyż dzięki nim można zrozumieć, co robimy. Nie chcemy, żeby inne państwa mogły zdobyć taką wiedzę, nie chcemy żeby inne systemy uczyły się na naszych danych.

– Istotnym elementem suwerenności cyfrowej jest tworzenie lokalnych modeli językowych – przekonywała Agnieszka Karlińska, kierowniczka Zakładu Dużych Modeli Językowych w Naukowo-Akademickiej Sieci Komputerowej – Państwowym Instytucie Badawczym oraz kierowniczka projektu HIVE AI. – W wypadku modelu PLLuM wykorzystujemy legalne polskojęzyczne dane wysokiej jakości na wszystkich etapach uczenia. Mówię o zbiorze liczącym miliardy słów. Optymalnie byłoby, gdyby to były biliony, ale do tego poziomu jeszcze nie doszliśmy. Opracowujemy również szczegółową dokumentację techniczną zgodnie z postanowieniami AI Act. Celem prac związanych z weryfikacją i ewidencją danych jest zagwarantowanie, że korzystanie z naszych modeli nie będzie się wiązało z ryzykiem naruszenia praw autorskich. O jakość danych dbamy szczególnie na etapie dostrajania modeli. Wyróżnikiem jest nacisk na opracowywanie danych organicznych, a więc tworzonych ręcznie przez dużą grupę anotatorów według autorskiej typologii. W wielu modelach zagranicznych bazuje się na danych syntetycznych, czyli pozyskiwanych z innych dużych modeli językowych, np. modeli DeepSeek, co rodzi wiele problemów.

AI Factory należy rozumieć jako zintegrowaną całość, w której technologia jest multiplikatorem ludzkich kompetencji w procesie tworzenia innowacyjnych produktów

Jakość danych szkoleniowych

– Te dane są szybkie do pozyskania, mają też często całkiem wysoką jakość, ale jeżeli będziemy korzystać z nich na dużą skalę, zetkniemy się ze zjawiskiem negatywnego transferu językowego – kontynuowała Agnieszka Karlińska. – Modele uczone na danych syntetycznych będą odpowiadały w języku polskim, ale nie w pełni naturalnie. Ważne jest, żeby korzystać z różnych rozwiązań o otwartym kodzie. W wypadku polskich modeli transfer wiedzy i kompetencji z otwartych modeli wielojęzycznych uczonych na zdecydowanie większej puli danych ma ogromne znaczenie. Z drugiej strony generuje to wiele ryzyk. Widzimy to, pracując z modelami bazującymi na etapie dostrajania na danych syntetycznych. Podam przemawiający do wyobraźni przykład, którym zazwyczaj się posługujemy. Maile tworzone przez takie modele zaczynają się od „Mam nadzieję, że zastałem Pana w dobrym zdrowiu i nastroju”. Takie kalki językowe występują bardzo często. Jest mnóstwo błędów fleksyjnych, składniowych, a tego chcemy uniknąć. Warto zwrócić uwagę na jeszcze jedną kwestię, a mianowicie bezpieczeństwo modeli. Nasze badania pokazują, że modele uczone na danych przede wszystkim w języku angielskim są dobrze zabezpieczone, ale gdy używamy języka angielskiego. Kiedy testujemy ich bezpieczeństwo i próbujemy je zaatakować podchwytliwymi promptami w języku polskim, bardzo łatwo je złamać i skłonić do generowania toksycznych i niezgodnych z prawem treści. To kolejny argument za rozwijaniem lokalnych modeli.

Po co nam autorskie modele?

– Dlaczego zatem warto budować własne modele językowe? – zapytała Magdalena Kasiewicz. – Czy jest to część strategii państwa? Wiele osób podchodzi do tego sceptycznie, twierdząc, że budowanie własnych modeli jest bardzo dużą inwestycją, wiążącą się jednak z wieloma zagrożeniami. Chodzi m.in. o utrzymanie tych modeli na odpowiednim poziomie. Czy w ogóle możemy być konkurencyjni, czy ma to sens?

– Zarówno Agnieszka Kasiewicz, jak i ja znamy dużo anegdot o różnych wyzwaniach, bo nie da się ukryć, że to jest trudne przedsięwzięcie – wyjaśniła Pamela Krzypkowska. – Budowanie takiego modelu na legalnych danych, zdobywanie ich, tworzenie danych organicznych, a nie syntetycznych, to są skomplikowane procesy, do których potrzeba talentu, ale też ludzi i pieniędzy. Uważam jednak, że powinniśmy mieć wybór. Nasz model może być słabszy, ale dla kogoś z różnych powodów jednak przydatniejszy, np. dobrze rozumieć język polski. Polecam nasze dokumenty ministerialne, czyli planowaną strategię cyfryzacji do 2035 r. i nowe założenia do polityki sztucznej inteligencji po konsultacjach. One wszystkie mówią o strategicznym, optymalnym podejściu, czyli nie wszystko budujemy, bo wszystko musi być nasze, polskie. To ma być robione rozsądnie, odpowiednio do potrzeb.

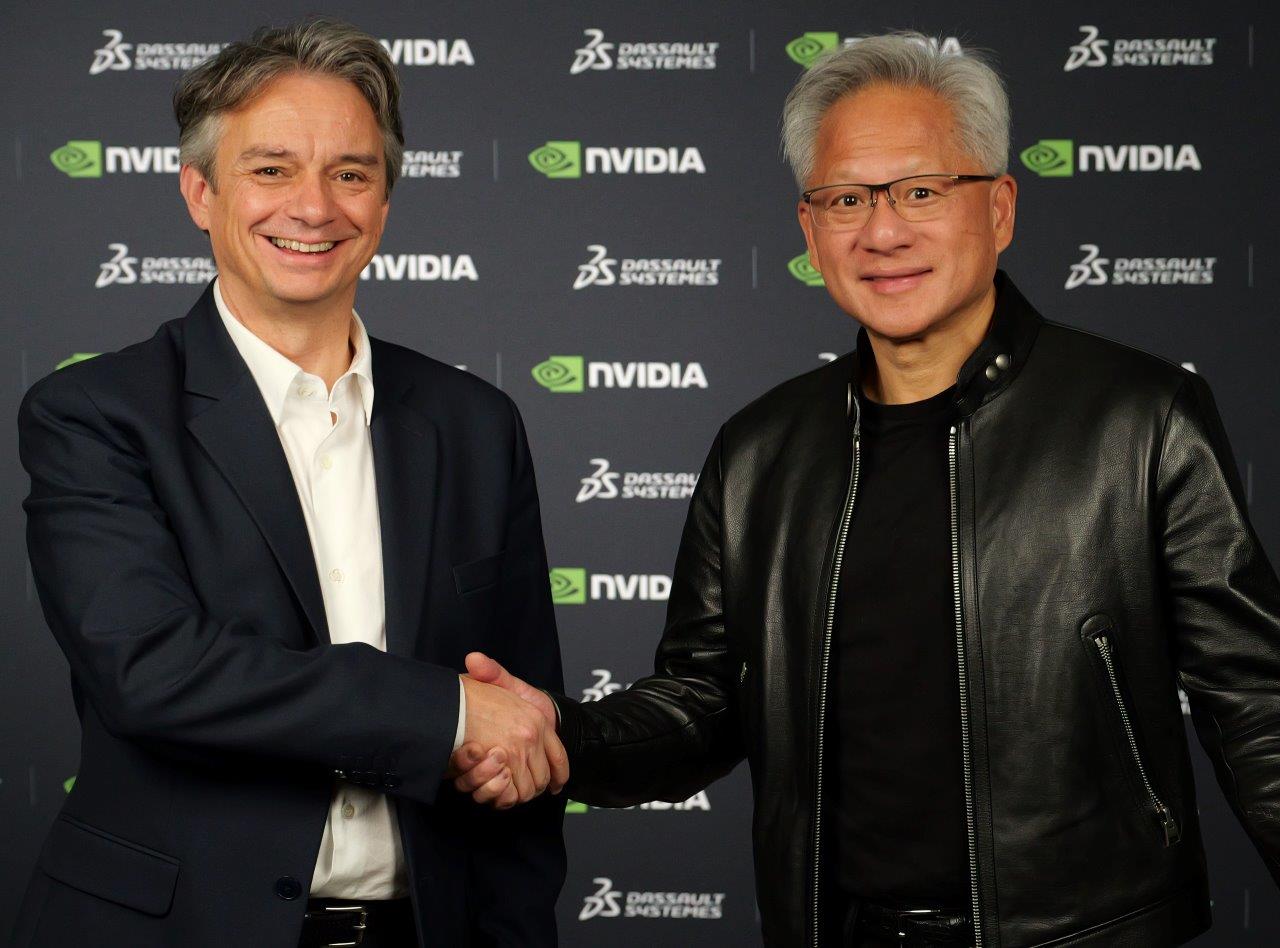

– Pamela Krzypkowska poruszyła bardzo ważny wątek – stwierdził Robert Pękal. – Czy warto rozwijać własne modele? Uważam, że tak, choć na pewno nie od zera. Oczywiście są na świecie duże modele i one w wielu zastosowaniach będą lepsze od naszych. Sam jednak niedawno natrafiłem na ciekawy przypadek. Szukałem konkretnego urządzenia, które przedstawiłem na zdjęciu, i okazało się, że żaden z czołowych modeli multimodalnych nie potrafił go znaleźć. Zrobiła to standardowa wyszukiwarka obrazem Google. Chodziło o zwykły panel domofonu. To pokazuje, że nawet największe modele mają swoje luki, zwłaszcza co do lokalnej specyfiki, którą mogą wypełnić bardziej wyspecjalizowane rozwiązania. Model otwartoźródłowy powinien być rozwijany i uczony na podstawie naszego dziedzictwa kulturowego. Duże, zagraniczne modele nigdy nie będą miały pełnego dostępu do specyfiki naszego języka i zasobów, dlatego ważne jest budowanie własnych rozwiązań. Mamy już na tym polu znaczne sukcesy, takie jak modele PLLuM i Bielik, które zdobyły międzynarodowe uznanie. Dowodem jest fakt, że w czerwcu 2025 r. prezes Nvidii Jensen Huang wymienił Bielika jako jeden z dowodów innowacji, nawiązując współpracę z jego twórcą, Sebastianem Kondrackim. Aby takie modele mogły powstawać i być efektywnie trenowane, niezbędna jest zaawansowana infrastruktura obliczeniowa.

– W tym obszarze również jesteśmy doceniani – dodał Robert Pękal. – Prezes Nvidii wyróżnił także nas, PCSS, za rozwój rozwiązań na styku procesorów graficznych (GPU) i kwantowych (QPU). Tworzymy platformy do obliczeń hybrydowych (CPU, GPU, QPU) i współpracujemy z Nvidią przy opracowywaniu narzędzi, które optymalizują proces uczenia modeli sztucznej inteligencji.

– Wrócę do wątku wyboru, bo, moim zdaniem, jest on istotny – wtrąciła Agnieszka Karlińska. – Mimo że odpowiadam teraz za rozwój modeli PLLuM, nie uważam, że zawsze będą one najlepszą alternatywą. W jaki sytuacjach znajdziemy lepsze? Niekoniecznie w sytuacji, gdy zależy nam na konkretnym zadaniu, ale nie mamy danych do dostrojenia modelu. Wtedy często lepiej skorzystać z jakiegoś modelu większego, zagranicznego. Po prostu te modele były uczone na większych zbiorach danych i są dostrojone do wielu zadań. Wykorzystano do tego miliardy instrukcji (czyli zestawów promptów i wzorcowych odpowiedzi), podczas gdy w polskim wariancie są to na razie dziesiątki tysięcy, a więc jest to zupełnie inna skala. Model uczony na mniejszych zbiorach danych nie będzie miał tak różnorodnych kompetencji, za to możemy skupić się na rozwijaniu bardzo konkretnych kompetencji i to jest nasza mocna strona.

Atuty polskich modeli

– Chciałabym zwrócić uwagę na dwie sytuacje, w których nasze modele mają przewagę – podkreśliła Agnieszka Karlińska. – Po pierwsze, jeżeli zależy nam na generowaniu dłuższych tekstów w języku polskim. Mówiłam wcześniej o kalkach językowych, o negatywnym transferze językowym. To był właśnie powód, dla którego Comarch i PKO BP wdrożyły w tym roku modele PLLuM. Chodziło o przewagę w generowaniu treści w języku polskim. Po drugie, jeżeli zależy nam na konkretnych zadaniach i chcemy model dostroić, ponieważ w biznesie to jest zazwyczaj kwestia kilku zadań, a niekoniecznie całego szerokiego zestawu kompetencji modeli. W takiej sytuacji warto wziąć właśnie model PLLuM albo Bielik. Model mniejszy, który jest już zaadaptowany do języka polskiego i dostrojony na polskich instrukcjach, i który można tych kilku zadań stosunkowo łatwo douczyć. Wtedy rezultaty są lepsze.

– A co z AI GigaFactory? – spytała Magdalena Kasiewicz. – To jest bardzo ważny projekt dla Polski. W czerwcu tego roku składaliśmy dokumenty w tej sprawie? Czym się różni od AI Factories?

– Chodzi o rodzaj przedsięwzięcia. AI Factory jest instytucją głównie naukową, choć ma element komercyjny i budowania ekosystemu. Z kolei AI GigaFactory jest projektem superkomercyjnym, ma tworzyć infrastrukturę i cały ekosystem między państwem i naukowcami, ale także sektorem prywatnym. Jest to projekt Komisji Europejskiej, wpisany w AI Action Plan, który został ogłoszony na szczycie w Paryżu – wyjaśniła Pamela Krzypkowska.

Zobacz również